本文来自微信公众号“学术头条”。

一直以来,人类使用芯片来训练强大的人工智能(AI)模型;如今,AI也可以反过来用于加速并优化芯片设计了,且可在数小时内生成超越人类设计或同类芯片布局,而无需耗费数周或数月的人力。

日前,Google DeepMind在一篇Nature增刊文章中详细介绍了他们用于设计芯片布局的新型强化学习方法——AlphaChip,及其对芯片设计领域的影响。此外,他们也发布了一个预训练的检查点,公开了模型的权重。

据介绍,AlphaChip是首批用于解决实际工程问题的强化学习方法之一,可以更加快速、低廉、节能的生成超越人类设计的芯片布局,目前已经被用于设计谷歌定制AI加速器张量处理单元(TPU)的最近三代超人芯片布局,以及全球多地从数据中心到手机的芯片。

半导体公司联发科高级副总裁SR Tsai认为,AlphaChip的开创性AI方法彻底改变了芯片设计的关键阶段。

AlphaChip是如何工作的?

芯片布局设计并不是一项简单的任务。计算机芯片由许多相互连接的模块组成,包含多层电路组件,所有这些组件都通过极细的导线连接。同时,设计过程中有许多复杂且交织的设计约束需要同时满足。由于其复杂性,芯片设计人员在过去60年中一直难以实现芯片平面规划流程的自动化。

类似于AlphaGo和AlphaZero学习围棋、国际象棋和将棋的方式,Google DeepMind推出了AlphaChip,将芯片平面规划视为一种游戏。

从一个空白的网格开始,AlphaChip逐个放置电路元件,直到完成所有元件的布局。然后,根据最终布局的质量,模型会获得相应的奖励。AlphaChip通过一种新颖的“基于边缘”的图神经网络,学习芯片组件之间的关系,并能够在不同的芯片上进行泛化,从而使AlphaChip能够改进其设计的每一个布局。

使用AI设计AI加速器芯片

据官方博客介绍,自AlphaChip首次被提出以来,其生成的超人类芯片布局已被用于每一代谷歌的TPU。这些芯片使得基于谷歌Transformer架构的AI模型能够大规模扩展。

从大语言模型到图像和视频生成器,TPU是生成式AI系统的核心。在设计TPU布局时,AlphaChip首先在前几代的芯片模块上进行练习,如片上和芯片间网络模块、内存控制器和数据传输缓冲区。这一过程称为预训练。

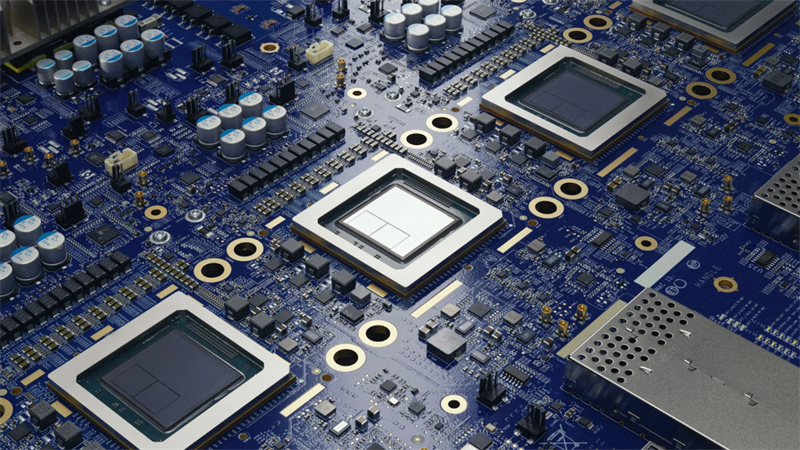

图|谷歌数据中心内的一排Cloud TPU v5p AI加速器超级计算机。

与以前的方法不同,AlphaChip是一种基于学习的方法,这意味着它会随着解决芯片放置问题的更多实例而变得更好、更快。这种预训练显著提高了其速度、可靠性和放置质量。

随着每一代TPU的演化,AlphaChip设计了更好的芯片布局,加速了设计周期,并带来了性能更高的芯片。

图|条形图显示了AlphaChip设计的芯片块在三代Google TPU中的数量,包括v5e、v5p和Trillium。

图|条形图显示了AlphaChip在谷歌三代TPU中平均减少的线长,并与TPU物理设计团队生成的布局进行了比较。

AlphaChip的影响力如何?

据介绍,AlphaChip的影响不仅限于谷歌内部,还扩展到了整个Alphabet公司、研究界以及芯片设计行业。除了设计像TPU这样的专用AI加速器,AlphaChip还为Alphabet旗下的其他芯片生成布局,如谷歌Axion处理器,这是谷歌首个基于Arm的通用数据中心CPU。

外部组织也在采用并扩展AlphaChip。例如,联发科利用AlphaChip加速其最先进芯片的开发,如三星手机中使用的Dimensity Flagship 5G,在提升性能的同时,也优化了功耗和芯片面积。

AlphaChip引发了AI芯片设计领域的工作热潮,并已扩展到芯片设计的其他关键阶段,如逻辑综合和宏块选择。

创造未来的芯片

谷歌方面认为,AlphaChip有潜力优化芯片设计周期的每一个阶段,从计算机架构到制造,并将彻底改变智能手机、医疗设备、农业传感器等日常设备中的定制硬件芯片设计。

他们也透露,新版本的AlphaChip正在开发中,他们期待与整个社区合作,继续革新这一领域,迎接更加快速、低廉、节能的芯片未来。

素材来源官方媒体/网络新闻