本文来自微信公众号“陈根谈科技”,作者/陈根。

最近,在量子技术领域又发生了一件大事,就是12月4日,IBM公布了它们在量子计算领域的多项新进展。内容量很大,我后面会和大家解释,为什么说这次IBM的进展是量子技术的大事。

第一项进展,是IBM正式推出了第三代量子芯片Heron,第二项进展,是IBM推出了第一台拥有1000多个量子比特的量子计算机Condor,更重要的是,IBM表示,现在将转变方向,专注于让机器更具有容错性,而不是更大规模的量子比特。当然,这里面有很多名词大家听了会有点不理解,简单来说,这三项技术都传递出一个信息,就是量子计算,终于要走向实用化了。

之前在各种新闻的报道里,我们也可能听到过很多量子计算方面的突破,但对于当时来说,所有的突破,其实都是对于量子计算这一项技术的探路。那么这一次是怎么回事呢?这一次,和之前的每一次,有什么不同呢?

其实IBM公司一直很专注于研究量子计算机,它们在之前也获得了很多进展,对于量子计算机来说,一个非常重要的参数,就是它能操控多少个量子比特,操控越多的量子比特,量子计算机的运算速度也就越快。

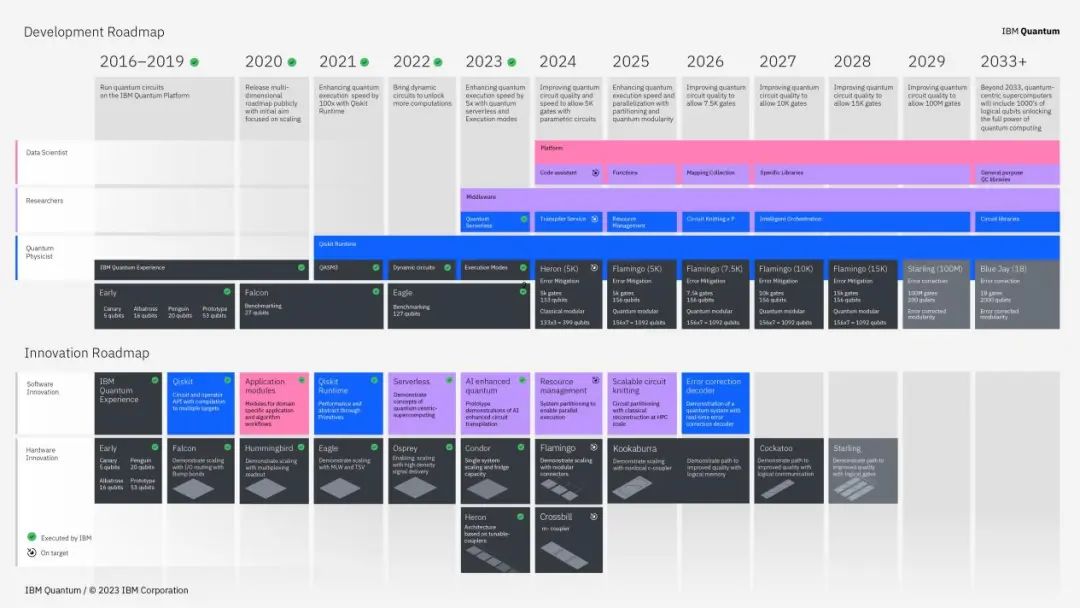

这几年来,IBM每年都如期实现了量子比特翻番的规划,相继在2021年推出127个量子比特的量子计算机Eagle,2022年推出了433个量子比特的量子计算机Osprey,今年则是推出了1121个量子比特的量子计算机Condor。

IBM表示,Condor为扩展到完全纠错、互连、超过100万量子比特的量子计算机奠定了基础。

当然,除了量子比特之外,要实现量子计算,还需要考虑到量子比特的质量。事实上,近年来,虽然科学家操纵量子比特的数量在不断提高,但同时也面对着越来越严峻的量子计算精准度的技术难题。

究其原因,一方面,与经典比特不同,量子比特容易受到外部干扰和噪音的影响。这包括热噪声、电磁干扰等。这些干扰会导致量子比特的误差,从而降低了计算的精确性。而随着量子比特数量的增加,噪音和误差的影响也会增加,这对于构建大规模量子计算机来说是一个严重挑战。

在大规模系统中,精确度问题可能会变得更加突出,因为误差可能会在不同量子比特之间传播并相互作用,导致不可预测的结果。于是,IBM在扩大量子比特数目的同时,也开始侧重量子硬件性能、错误减少和纠正。此次发布的量子芯片Heron,虽只拥有133个量子比特,错误率却创历史新低,设备性能相比127量子比特Eagle处理器提高了3-5倍,且几乎消除了串扰。

如何能够让量子计算实用化,一定会是越来越热门的一个问题,因为今天人工智能的发展已经被算力卡住了,而真正能打破人工智能算力瓶颈的,正是量子计算。而一台有用的量子计算机,则需要更好的量子比特和更好的门,只有量子比特扩展到足够大、足够快、足够精确,才能解决经典系统难以解决的问题。

IBM已经在转变方向,专注于让量子计算机更具有容错性,让量子计算机走向实用化。虽然客观来说,我们离制造一台拥有数百万高质量量子比特的量子计算机还有些远,但实用的量子计算好像已经不再遥远。