本文来自半导体产业纵横。

作为GPU计算市场的新手,英特尔可能降低价格,同时提供更高的性能。

在半导体行业中,体积比架构更加重要。如果设计中的IP不能分散到大量客户以解决更广泛的工作负载,那么出色的设计并不能带来什么。

英特尔对GPU业务一点也不陌生。仅在最近十年就见证了基于“Larrabee”X86的GPU的兴起,它没有与Nvidia和AMD(ATI)替代产品竞争的性能,并且作为HPC计算的许多核心处理器的“Knights”系列被回收,英特尔在仅仅两代人之后就将其作为计算引擎淘汰。

用于Core i5、i7或i9 PC处理器的Iris系列集成图形电路,后者重新打包为Xeon E3服务器CPU系列,集成GPU用于视频流和VDI工作负载。英特尔尽其所能忽略这些Iris增强型服务器CPU中固有的相当强大的GPU计算能力。

英特尔正在用基于Xe架构的离散GPU家族来解决这个问题,该公司最终致力于拥有一个广泛而深入的GPU计算平台,主要是英特尔意识到,如果他们不在数据中心吃掉自己的CPU计算份额,那么其他两家主要的GPU加速器制造商——AMD和Nvidia都会推出相应的CPU。

好久不见

这种Xe GPU策略是其Gen11 Iris PC显卡的演变,并在2018年12月的英特尔创新日上首次详细介绍,当时英特尔表示将创建一个新架构,该架构将具有独立CPU和集成GPU,所有这些都基于相同的Xe架构将跨越“从teraflops到petaflops”,范围从针对PC客户端优化的低端GPU一直到针对运行AI和HPC工作负载的数据中心系统优化的大型计算引擎。

近两年后,在Hot Chips上,英特尔详细阐述了这一新GPU系列的设计,并谈到针对特定工作负载调整Xe GPU微架构,并使用不同的工艺、封装,有时甚至是小芯片组合。Xe LP是一种低功耗GPU,最初在“Tiger Lake”CPU中销售,然后在用于服务器工作负载的离散SG1和DG1 GPU中免费使用;英特尔服务器XG310 GPU加速器于2020年11月宣布并与中国系统制造商H3C共同设计,使用Xe LP SG1变体。

XeHPG系列针对高性能游戏和数据中心流媒体和图形计算工作负载。Xe HP将HBM2e内存添加到GPU复合体中,并在单个封装上扩展到四个小芯片,旨在实现更强大的媒体处理和AI工作负载。最后,Xe HPC系列的目标是浮点和混合精度计算,用于AI训练和HPC模拟和建模工作负载,而Knights系列则留下了一个漏洞。

Xe HPC系列包括“Ponte Vecchio”离散GPU,英特尔上周表示,它已开始向阿贡国家实验室发货,作为“Aurora”百亿亿级超级计算机的第二个设计中的主要计算引擎。

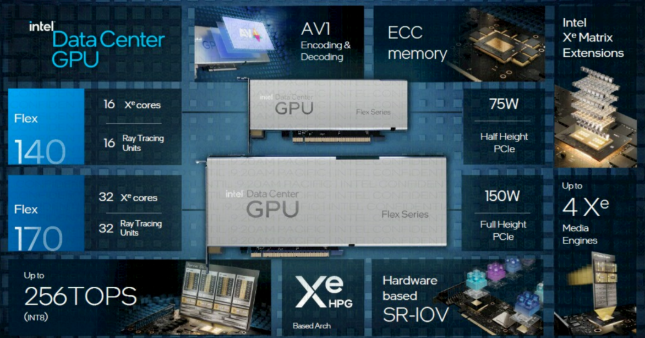

英特尔详细介绍的Flex系列140和170 GPU加速器属于Xe HPG系列,也称为Artic Sound-M系列。这些Flex系列卡于8月推出,但这些设备的许多架构细节并未透露。

不要被这些独立GPU卡的相对大小误导。Flex系列140基于一对DG2-128 GPU,其中八个Xe图形内核运行在1.95 GHz、两个媒体引擎和八个共享12 GB GDDR6内存的光线追踪单元。

Flex系列170具有单个DG2-512 GPU,具有32个运行频率为2.05 GHz的Xe内核、两个媒体引擎和32个共享16 GB GDDR6内存的光线追踪单元。

Xe HPG内核具有16个256位向量引擎和16个1,024位XMX矩阵数学引擎,这两个引擎都对AI推理很有用,具有192 KB的共享L1缓存。这两个引擎是我们关心Flex系列的原因。

重点关注媒体转码和云游戏,因为在数据中心很好地支持这种工作负载意味着英特尔可以与Nvidia竞争在GPU领域的工作数据中心。如果英特尔GPU领域竞争,那么它也有能力构建更好的Xe HPC GPU加速器,比如“Rialto Bridge”离散GPU踢球器到Ponte Vecchio和“Falcon Shores”混合CPU-GPU设备。

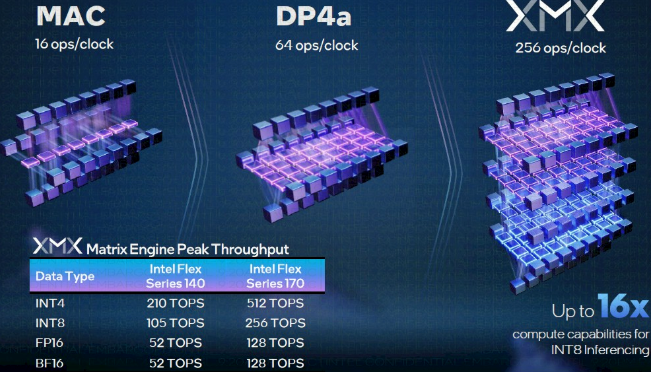

Xe HPC内核上的向量引擎每个时钟可以处理16次FP32、32次FP16和64次INT8运算,并具有一个专用的浮点执行端口和另一个用于整数和扩展数学函数处理的端口。

XMX矩阵引擎是一个四深脉动阵列,类似于Google的TPU和Amazon Web Services的Inferentia芯片。Xe HPC内核上的矩阵引擎每个时钟可以处理128个FP16或BF16浮点、256个INT8或512个INT4运算。GPU可以同时将工作分派给向量和矩阵引擎。

配备两个DG2-128 GPU的Flex系列140在媒体处理方面将比配备一个DG2-512 GPU的Flex系列170高出近2倍,但其运算能力仅为Flex系列170的41%。

预计Flex系列140比Flex系列170便宜得多,因此AI的性价比差距两个设备之间的推断可能没有媒体处理那么大。这个想法是让数据中心GPU既可以用于媒体处理,也可以用于云游戏,但在AI推理方面也做得相当好,这不仅越来越成为数据中心的工作负载,

英伟达数据中心GPU

Nvidia刚刚推出了具有光线追踪、视频编码和AI推理处理功能的“Lovelace”AD102数据中心GPU,而英特尔对新的Nvidia L40 GPU加速器的了解还不够,无法与Flex系列140和150卡进行比较。但英特尔确实将其数据中心GPU与Nvidia A2和A10设备进行了对比,

人工智能如何嵌入应用程序的一个很好的例子是在流视频中使用人工智能推理进行对象分类和对象检测。英特尔有一个名为DLStreamer的新工具,可以优化Xeon SP CPU和Flex系列GPU的使用,以在视频流输入中进行对象识别,如下所示:

正如在该框图底部看到的那样,当DLStreamer在CPU和GPU上运行部分代码时,解码视频并在流上运行Yolov5对象检测模型的流的数量增加了67%。机箱中的Flex系列GPU通过CPU-GPU组合驱动150个流来驱动90个流。

我们真正想要做的是直接比较Nvidia加速器和Flex系列在这些工作负载上的比较,英特尔不得不使用Resnet50进行对象分类,使用SSD-MobileNet进行对象检测:

Flex系列170在视频流中的对象分类方面的性能比Nvidia A10高35.4%,在视频流中的对象检测方面的性能提高33.3%。

Nvidia A10在惠普(Hewlett Packard Enterprise)和CDW的售价约为8,400美元,在戴尔(Dell)的售价则低至5,700美元。为了在视频推理方面提供同样的价格,英特尔可能会对Flex系列170收取11,200美元的价格。如果Flex系列170的售价为8400美元,英特尔的性价比将提高25%,而售价为6400美元的价格/性能将提高43%。

作为GPU计算市场的新手,英特尔可能降低价格,同时提供更高的性能。