本文来自微信公众号“IT时报”,作者/郝俊慧。

AI风暴席卷全球时,“能源阴影”始终如影随形。

“真正的电力短缺局面即将到来。”半导体分析机构SemiAnalysis在一份报告中指出,全球数据中心关键IT电力需求将在2026年激增至96吉瓦(1吉瓦=100万kW),其中人工智能将消耗约40吉瓦。

这样的增速对于全球而言均是巨大挑战。数据显示,全球数字技术耗电量从2018年占比不到2%提升至2023年的10%,预计到2030年占比将达到20%。

比特和瓦特能否和谐共存,是影响算力能否高速狂奔的关键因素,液冷技术的出现,带来了解开难题的“钥匙”。但与此同时,液冷数据中心建设者和运营者必须先解决高算力、低PUE和低TCO的“不可能三角”关系。

“我们做过内部测算,当单个机架功率密度超过10kW之后,采用冷板液冷架构的单kW制冷成本将低于传统的风冷架构。”近日,第五届中国数据中心绿色能源大会暨第十届中国(上海)国际数据中心产业展览会举办期间,在接受包括《IT时报》在内的媒体采访时,曙光数创副总裁兼CTO张鹏预测,随着算力需求的增加,机架功率密度将快速上升,新建机架功率20kW起步,并向60kW普及,因此,未来十年是冷板液冷技术的高速发展期,液冷数据中心占比将超过六成。

“不过,再过十年将是浸没式液冷技术的天下”,张鹏话锋一转说道。在当日展台上,曙光数创摆放着一台浸没在液体中的服务器,这台“缸式”浸没液冷计算机,不仅可以让PUE降至1.05,而且最高可支持的单机架功率可达210kW,“这只是一代产品,刚刚商用的二代产品最高可支持功率已达575kW,而正在研制的三代产品将高于750kW,它的单kW制冷成本远远低于风冷和冷板液冷技术。”

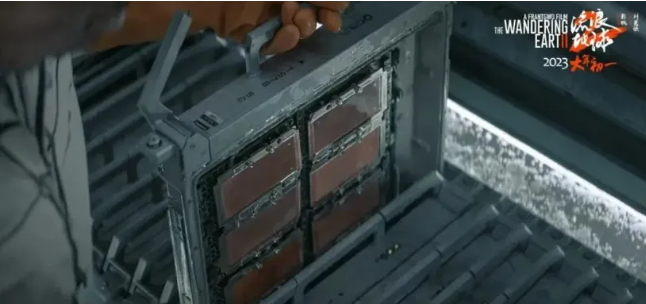

电影《流浪地球2》中,为了让地球启动“流浪模式”,人类必须重启杜勒斯、东京、北京三地根服务器,其中位于北京的“未来航天中心计算机”便是一座“浸没”式的水下数据中心,其原型正是曙光数创的相变浸没液冷计算机。

如今,科幻仍是想象,科技已先至。

液冷不再是选择题

对于数据中心而言,液冷架构已不再是选择题。

随着着人工智能、大数据分析、虚拟化和高端计算等技术的迅速发展,算力中心对计算能力的要求越来越高。截至2024年6月,英特尔第六代服务器处理器单CPU功耗已突破300W,英伟达最新的超级芯片GB200功耗达2700W,MGX集群算力密度达100kW/柜。

中国信通院发布的《算力中心冷板式液冷发展研究报告(2024年)》显示,高功耗、高密度的大型、超大型算力中心是未来建设的重点。如今,大型算力中心的单机架功率密度已接近8kW,少数超大型算力中心的单机架功率密度已达20kW。

然而,算力中心有限的电力承载能力成为限制算力提升的主要因素。张鹏告诉《IT时报》记者,北京某个智算中心采用了传统的风冷架构,但GPU服务器的单机架功率密度达60kW以上,这几乎已是风冷的上限,当大模型并行训练时,常常因任务太多、散热能力不足而产生局部热点,甚至宕机,因此只能将GPU降频使用,导致可使用算力大幅下降。

液冷是将液体作为服务器的散热方式,它的应用可以使算力中心计算能力得到飞跃提升。目前主流液冷架构有两种:冷板和浸没式。

冷板路线是在服务器背后直接加装液冷板,将数据中心IT设备的热量传导到冷板上,然后通过冷板内部液体循环实现换热,再通过室外冷却塔等设备实现散热。

浸没式则是直接将服务器电子元器件浸入特制具备高热传导性的冷媒中,冷媒沸点低,可以快速将服务器产生的热量传导出去,从而产生更高效的散热效果。

目前冷板式液冷是最主流的液冷方案,IDC近日发布报告称,2023全年中国液冷服务器市场规模达到15.5亿美元,其中95%以上均采用冷板式液冷解决方案。

《算力中心冷板式液冷发展研究报告(2024年)》透露,某算力中心引入了冷板式液冷系统后,将其应用于高密度计算节点。在传统空气冷却技术下,每个机柜的功率密度仅为8-10kW,而在采用冷板式液冷技术后,单机柜的功率密度大幅提升至33kW,可支持128颗CPU,单机柜最大支持66kW供电。

“从2011年启动液冷相关技术的研究,曙光的产品已连续三年在液冷领域保持市占率第一,”张鹏透露,国内不少互联网大厂均是曙光液冷方案的“买单人”,“某互联网大厂去年大量采购了我们的产品。”

图源:曙光数创

中国电子技术标准化研究院发布的《液冷数据中心白皮书》显示,2023年曙光数创在液冷基础设施市场的份额高达61.3%,连续3年蝉联行业榜首。

冷板式液冷将统治未来十年

相较于风冷系统,液冷技术从根本上改善了主设备的散热形式,更能满足高密机柜、芯片级精确制冷,具有更节能、噪声低等优点。

张鹏告诉记者,目前曙光数创冷板式液冷数据中心的PUE已经可以做到1.2以内,而相变浸没式数据中心能做到1.04,几乎接近于1。

PUE是数据中心消耗的所有能源与IT负载消耗的能源比值,如果比值为1,意味着数据中心所有能源都将为算力服务。去年6月开始实行的《绿色数据中心政府采购需求标准》明确要求,数据中心PUE不高于1.4,2025年起数据中心PUE不高于1.3。

三家电信运营商2023年联合发布的《电信运营商液冷技术白皮书》也显示,2024年新建数据中心项目10%规模试点应用液冷技术,推进产业生态成熟;2025年及以后开展规模应用,50%以上数据中心项目应用液冷技术。

液冷数据中心逐渐普及的一个重要原因是,冷板式液冷技术的成本不断下降。相关数据显示,2022年液冷数据中心1kW的散热成本近6500元,相比2022年下降54.2%,预计2023年1kW的散热成本降至5000元,与传统风冷的建设成本基本持平。

曙光数创也曾进行过市场摸底,2022年液冷服务器的渗透率约3%~5%,2023年上升至8%~10%,2024年之后有可能拉出一条上升直线,增长率可达30%~40%。其中大部分是冷板式液冷服务器。张鹏认为,10年内冷板式技术架构将成为智算中心的必选题,渗透率将有望最终定格为六成。

这个估算基本与中国算力格局相匹配。根据《2023~2024年中国人工智能计算力发展评估报告》,中国智能算力规模正处于高速增长状态。预计到2027年,中国智能算力规模将达1117.4EFLOPS,2022~2027年期间的年复合增长率为33.9%。

浸没式技术路线也逐渐获得市场认可,不过与其他发力单相浸没式液冷技术路线的友商不同,曙光数创从一开始便选了一条更难的路径——相变浸没式液冷技术。

相变浸没式液冷

为未来做好准备

翻阅各类液冷式数据中心报告,谈及冷板式和单相浸没式技术路线时,总有多个厂商的方案可供参考,但在谈及国产相变浸没式液冷技术时,厂商的名字只剩下一个——曙光。

所谓相变,即物质态势发生改变,浸没式的含氟冷却液在受热时发生相变成为气态,利用液体汽化的潜热吸收并带走服务器内发热元件产生的热量,从而大幅提升整个数据中心系统的换热效率,并在冷凝后相变为液体,再度循环进入液体箱,进而提高整个数据中心系统的换热效率。由此芯片核心温度降低20℃到30℃,芯片性能约可提升10%至30%,而单位算力的投资成本亦可降低,据测算,冷板液冷初投资可低于风冷,浸没相变液冷5年TCO即可低于风冷。

图源:壹图网

“每年的液体损耗在3%左右。”曙光展台工作人员告诉记者,曙光数创浸没相变液冷技术中不需要部署传统风冷设施,真正做到极致节能、全时全域自然冷却,节约能效大于30%。

据了解,目前相变浸没式液冷技术可实现功率密度高达250kW至500kW/浸没腔,曙光正在研制的三代产品预期功率密度超过750kW,而“液体进、液体出”的单相浸没式液冷技术,目前普遍支持的最高单机架功率在100kW左右。

《IT时报》记者在现场看到曙光一代相变浸没式液冷服务器机架模型,可支持八台智算服务器,其中每台智算服务器装有两块CPU和八块GPU,功率密度超过210kW,而这已经是曙光数创数年前的产品,新商用的二代产品功率密度已超过500kW。

从目前智算中心的建设需求来看,单机架密度超过500kW是比较高的门槛,即便210kW也已是民用数据中心的天花板。超算中心目前是相变浸没式液冷技术方案的主要场景。不过,随着GPU的迭代升级,来自智算中心的功率密度要求正在加速上升。英伟达最新推出的MGX超级AI工厂,可支持72块CPU,单台功率密度达100kW。

在更高密度、更大规模的计算系统到来之前,相变浸没式液冷技术方案做好了准备。

目前,国内只有曙光数创推出了相变浸没式液冷数据中心,在一些关键技术上实现了国产突破。

据张鹏介绍,由于冷媒的介电常数与空气不同,信号在浸没环境中传输路径的分布电容增加,导致高频信号衰减。这给主板设计和信号完整性(SI:Signal Integrity)带来了巨大挑战。主板上的CPU、GPU、内存、PCIe、高速网络的信号速率均高于1Gbps,此类信号在全浸环境下会出现明显的失真,严重影响信号可靠传输。曙光数创通过研究浸没环境下的高速信号衰减规律,针对关键高速信号传输进行了优化,形成了一整套针对浸没环境的高速信号设计规范,包含主板Layout规则、板卡材料要求、测试方法等多方面内容。