本文来自半导体,由半导体产业纵横(ID:ICVIEWS)编译自techspot。

非必要的消耗代价越来越高。

每隔几年,就会推出新一代的计算机处理器。很长一段时间以来,CPU似乎都保持着相同的功率水平,而GPU只增加了相对较小的数量。但如今,似乎所有供应商发布的高端机型都是需要大量功率的机型。

CPU是250W,GPU是450W,这些是不是太高了?制造商关心这个吗?在本文中,我们将揭开散热片,看看功率数据背后的真相,看看到底发生了什么。

为什么芯片需要电源并变热

CPU和GPU被归类为超大规模集成电路(VLSI),是晶体管、电阻器和其他电子元件的巨大集合,所有这些都是微观尺寸。

这种芯片需要电流通过它们才能执行它们设计的任务。算术逻辑单元通过切换大量晶体管来执行数学运算,以改变电路中其他地方的各种电压。

现代处理器使用一种称为FinFET(Fin场效应晶体管)的晶体管。可以将它们想象成两个岛屿之间的桥梁,在其中施加小电压会降低道路,从而使电流从一个地方流向另一个地方。

显然,这涉及通过岛屿和桥的电流,因此需要电力,如果没有它,芯片根本不会做任何事情。但是为什么它们会变热呢?

不幸的是,所有这些组件都对这种电流产生了阻力。实际数量确实很小,但考虑到CPU和GPU中的晶体管数量达到数十亿,累积效应非常明显。

指尖上的三十亿个晶体管。

一个典型的CPU可能只有十几毫欧的总内阻,但是一旦它有80A或更大的电流流过它,由于电阻而耗散的能量将超过每秒90焦耳(或瓦特,W)。

这种能量被转移到构成整个芯片的材料上,这就是为什么每个处理器在工作时都会变热的原因。大芯片需要主动冷却,以防止它们的温度升得太高,因此所有这些热量都需要转移到其他地方。

还有其他因素会影响散热量,例如电流泄漏,但如果处理器正在“损失”能量(以热量的形式),它将需要不断地“消耗”能量以保持功能正常。

换句话说,损失的热量与芯片的额定功率几乎相同。因此,让我们先来看看中央处理器,看看它们的功率需求这些年来是如何变化的。

CPU功率数据背后的隐藏真相

多年来,CPU供应商一直通过一个简单的数字来说明其处理器的功耗:热设计功耗或TDP。不幸的是,随着芯片设计的发展,这个数字已经经历了各种定义。

英特尔目前的定义是:

“在制造过程中,处理器在基频和最高结温下执行英特尔指定的高复杂性工作负载时,经验证不会超过时间平均功耗”。

换句话说,如果英特尔CPU的基本频率为3.4 GHz,最高温度为95°C(203°F),那么只要芯片在这些限制下运行,其额定功率将等于TDP。

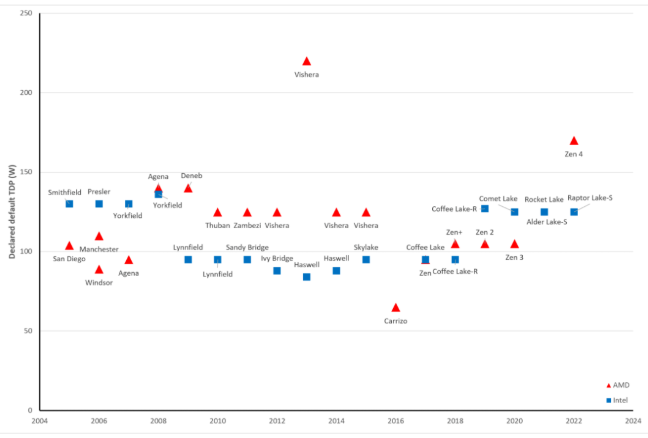

那么让我们来看看过去17年CPU的一些例子。在此期间,我们采用了每年发布的最耗电的台式机型号,而忽略了针对工作站等的型号。

除了一些孤立的案例,例如2013年的AMDFX-9590(TDP为220W),CPU的功率要求似乎非常一致。

唯一的问题是市场上几乎每个CPU都可以以远高于其基本频率的速度运行。上面提到的FX-9590的基础频率为4.7 GHz,但可以将时钟频率提高到5.0 GHz。那么会发生什么呢?

你可能会认为这是一个简单的答案:它会消耗更多的功率,从主板吸取更多的电流。不幸的是,情况并非总是如此,因为这取决于主板的BIOS中启用了哪些设置。

英特尔和AMD都有许多选项,所有选项都可以激活或停用(取决于BIOS中是否有选项),让CPU管理自己的功率和频率。

坚持使用英特尔一段时间后,实现这一目标的主要系统被称为Turbo Boost Technology。抛开1980年代风格的名称不谈,它的作用是主动控制CPU在给定负载下在一定时间内可以消耗多少功率。

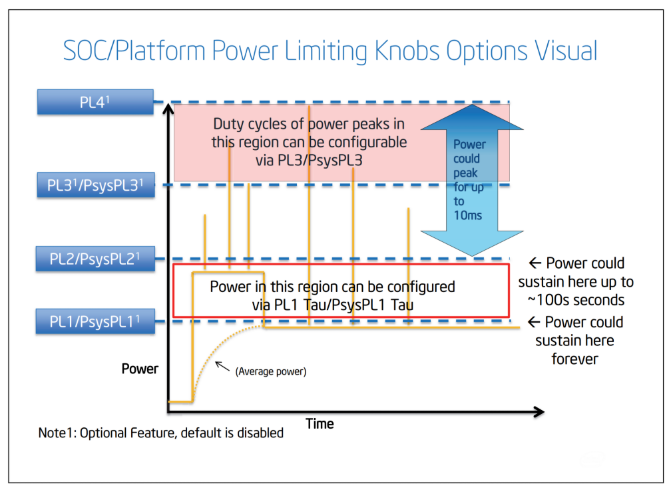

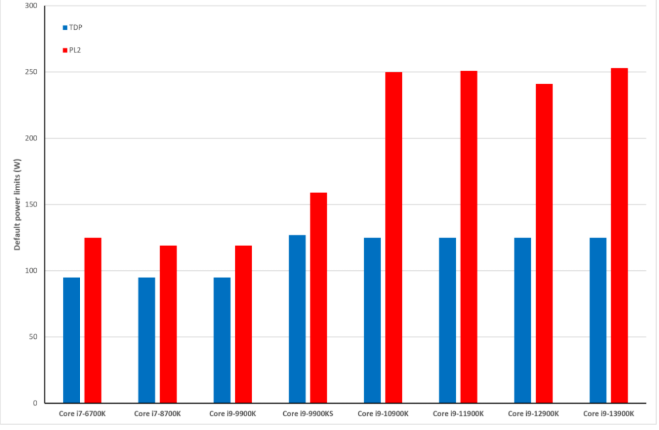

英特尔的CPU通常有两个这样的功率限制,PL1(又名TDP)和PL2。

请注意橙色功率曲线如何在一定时间内飙升至显著高于PL1的水平并升至PL2。在这里,CPU在其基本频率之上运行,但不一定以其最大时钟频率运行。

由于英特尔默认禁用PL3和PL4,我们可以将PL2作为CPU的实际最大功耗——它可能只有几秒钟(或者取决于BIOS设置,它可以永远这样运行),但它仍然是可能的最高功率。

那么PL2比PL1高多少呢?这个值随着每个新的处理器型号而波动,但让我们看看上面TDP图表中最近几年的值。

七年前,在酷睿i7-8700K之类的产品中,PL1和PL2之间只有30W的差异,但现在已经超过100W——在某些情况下,功率需求实际上翻了一番。

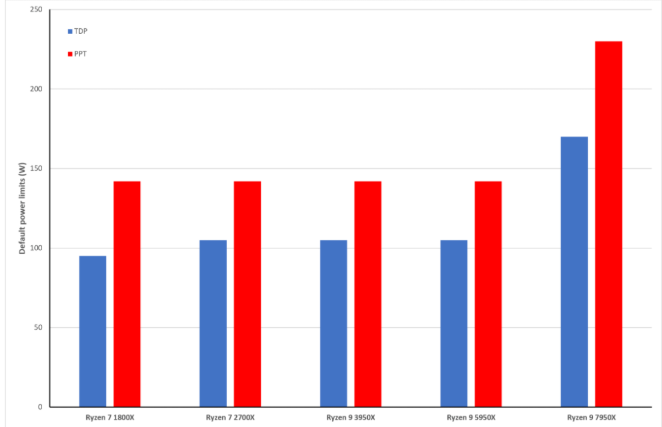

AMD没有使用与英特尔相同的标签和定义,但它们的CPU也可以消耗比TDP限制更多的功率。

上限以封装功率跟踪(PPT)形式给出——CPU在任何给定负载下可以消耗的最大功率。对于TDP为95W或更高的所有Ryzen台式机处理器,PPT等于1.34 x TDP。

所以现在有一点很清楚:尽管TDP相对静态,但在过去几年中,高端CPU的绝对最大功率要求肯定有所提高。

不过,主板供应商通过覆盖英特尔的默认功率限制和时间限制,并在BIOS中设置自己的值,使事情变得更糟。换句话说,一个主板上的CPU可能最大功率为120W,但在另一个主板上达到200W。

我们应该在这一点上进行评估,因为到目前为止显示的所有数据都是针对高端型号的——那些具有最高时钟速度和最多内核数量的型号。

幸运的是,中端和预算CPU的变化很小,仅仅是因为它们的内核总是比显示停止器少得多。

在台式机CPU市场的低端,英特尔流行的Core i3-12100F的TDP为58W(PL2为89W),而AMD的Ryzen 3 4100的TDP为65W——几乎与那些相同产品线一直如此。

然而,AMD最新的中端Ryzen 7600X的TDP为105W,比其前身5600X高出40倍。而英特尔的酷睿i5-12600K拥有高端芯片的TDP:125W。

所有这些都表明功耗明显下降,主要是高端机型,但并非完全如此。如果你想要一个拥有最多内核数和最高时钟速度的CPU,那么随之而来的是巨大的能源需求。

不幸的是,那些想要升级到最新的中档产品的人也可能不得不接受显著的能源涨价。

GPU

在CPU在功率方面相当温和的情况下,即使考虑到最近最大限制的提高,台式PC中的一个芯片随着每一代的更新而变得更大和更饥饿。就晶体管的数量、芯片尺寸和处理能力而言,图形处理芯片(GPU)是迄今为止大多数人将拥有的最大、最复杂的半导体设备。

今天游戏中的图形保真度达到了17年前只能梦想的规模,但相比之下,所有这些多边形、纹理和像素的功耗成本让CPU看起来很轻巧。

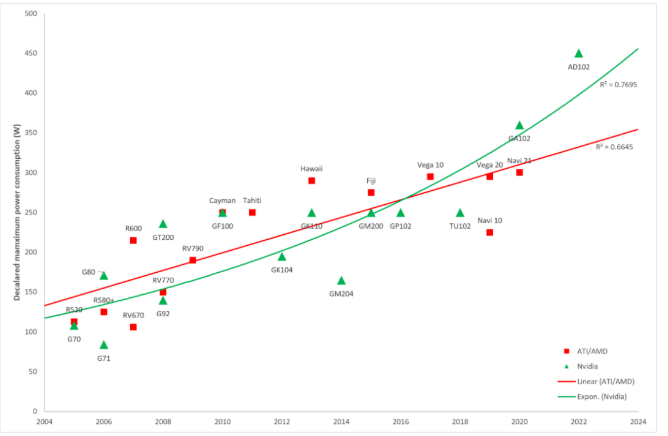

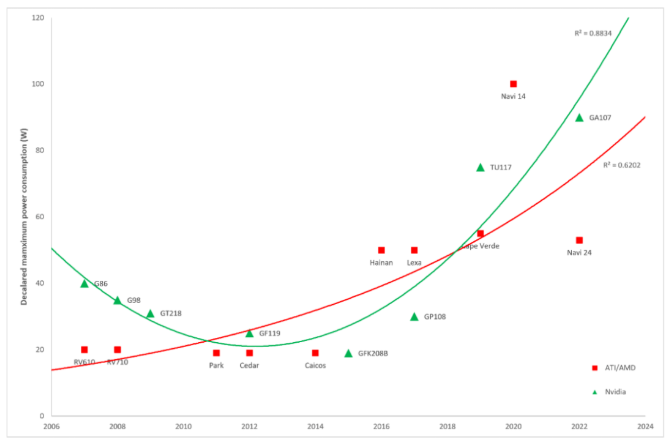

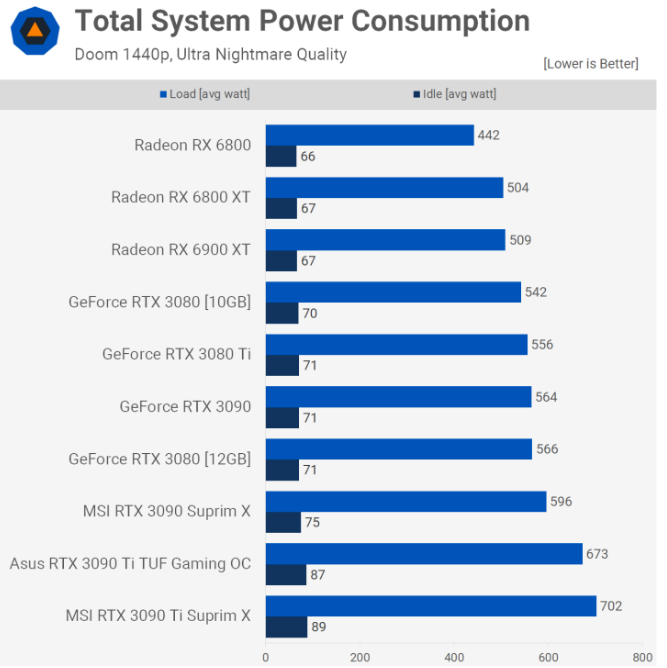

在这张图表中显示了每年从顶级供应商那里获取对功耗要求最高的消费级显卡。

AMD的Ryzen 9 7950X之类的产品可能会达到230W的最高功率,但近15年前高端GPU正在消耗这种功率水平。

正如图表所示,几乎没有迹象表明最强大的显卡需要更高功率的趋势将完全下降,因为两家供应商的趋势显然没有下降,尽管相关性不是很强。

随着英伟达推出GeForce RTX 4090,拥有760亿个晶体管和450W TDP的芯片,这一标准有了显著的飞跃。

那么GPU供应商真的根本不关心电源要求吗?

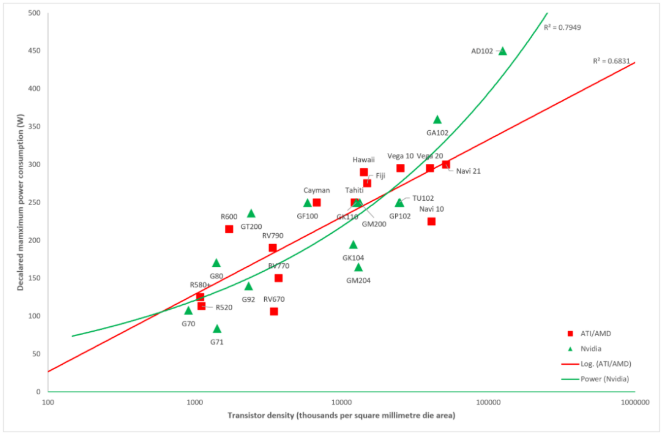

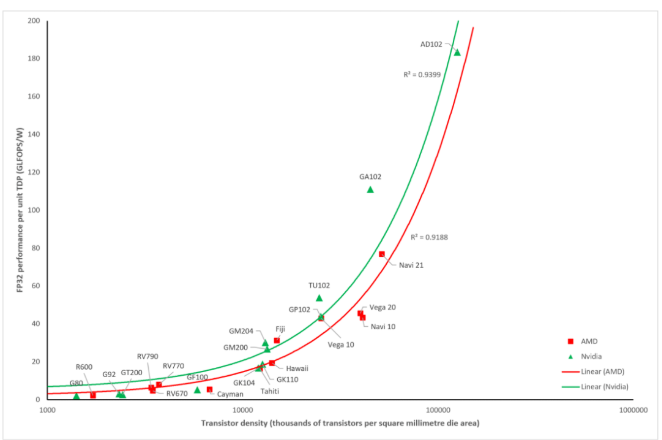

上图显示了与以前相同的芯片在每平方毫米芯片中封装的晶体管数量与显卡的TDP的关系。

管芯密度标度是对数的,因为近年来密度发生了巨大飞跃——线性标度会将几乎所有数据点打包到一个小区域中。

我们可以看到,随着GPU将越来越多的纳米级开关封装到其电路中,功率需求稳步上升,但不是以恒定的方式(是的,AMD线看起来很直,但请记住对数标度)。

非线性趋势都在增加,但增长率本身每年都在下降。这种密度和TDP之间的模式取决于供应商发布的新芯片,这些芯片是在改进的工艺节点上制造的。

这是半导体代工厂用来制造芯片的制造方法的名称。每个新节点都比其前身提供了多种优势:更高的密度、更低的功耗、更好的性能等等。

较新的工艺节点是GPU拥有数十亿个晶体管的原因。

并非所有这些改进都可以同时应用,但在GPU的情况下,它允许供应商创建真正巨大的处理器,具有出色的数字处理水平,以满足合理的功率要求。

例如,如果Navi 21使用与R520相同的节点制造,则所需的功率将很好地运行到kW区域。因此,虽然现在的能量水平相当高,但它们可能会更糟。

新工艺节点和GPU设计带来的好处不仅仅是降低功率水平。

自2006年第一个统一着色器模型出现以来,所有高端GPU的每单位功率计算能力几乎一直以惊人的速度增长。

如果采用上述数据,自2006年以来TDP的平均增长为102%,而FP32性能功耗比的增长则达到了惊人的5700%

虽然FP32处理吞吐量不是显卡的决定性质量,但它是游戏和3D图形最重要的功能之一。我们今天只有具有令人难以置信的图形和功能的游戏,因为最好的GPU变得更大更复杂。

尽管图形处理器比以往任何时候都好,而且它们的功率水平实际上并没有想象中那么糟糕,但它们的能耗水平仍在上升。即使是通常使用30W或更低功率的超预算GPU,在过去几年中TDP也出现了显著增长。

如果一个人希望购买一张英伟达显卡,它可以仅通过PCI Express插槽吸取其所有电流,那么实际上需要跳过整个Ampere库存。GeForce RTX 3050的TDP为100W,由于插槽的限制为75W,因此需要额外的电源连接器。

这样的显卡拥有比以往更强大的处理能力,但对于想要构建超低功耗系统的人来说,在显卡方面可供选择的选择越来越少。

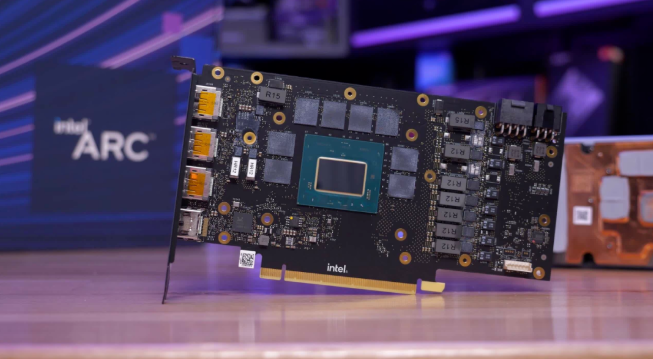

而且似乎没有任何迹象表明电力需求的增长会放缓,更不用说下降了。例如,英特尔最新进军显卡市场的Arc系列,目前以A770为首。

这张卡的芯片拥有214亿个晶体管,16GB GDDR6,TDP为225W。虽然它针对的是中端市场,但这种电力需求与四年前AMD和英伟达最大的芯片相同。

对于中端GeForce和Radeon卡来说稍微好一些,RTX 3060需要170W,RX 6600 XT需要160W,但所有领域的能源需求都在上升,远远超过CPU。

如果不是为了更好的工程,需求显然会高得多,但这里真正需要回答的一个重要问题是CPU和GPU是否需要太多的功率来提供它们所提供的功能。

多少是太多了?

关于CPU和GPU电力需求上升的两个最常见的抱怨是电力成本和产生的热量——让我们先来看看前者。

假设你有一台规格非常高的游戏PC,里面装满了金钱可以负担得起的一些最好的组件。让我们还假设你使用的是AMDRyzen 9 5950X,由轻度超频的英伟达GeForce RTX 3090 Ti支持。

当然,其中也会有其他部件(至少,主板、一些RAM和存储驱动器),但我们可以将它们放在一边,因为它们的综合能耗将远低于CPU或GPU.那么,在一些忙碌的游戏中,这台PC需要什么样的能力呢?670W到700W听起来怎么样?

现在想象一下,一年中的每一天,你每天都以这种方式使用PC 2小时。PC消耗的能量约为500 kWh(0.7 x 2 x 365)-相当于不间断地运行1.5 kW电热水壶近两周。

根据世界上的居住地以及电费支付的费率,每年使用此类PC的费用可能在70到280美元之间(不包括税费和额外费用)。

但与PC本身的总成本几千美元相比,这是一个相对较小的数额。取较高的值并计算每小时游戏的电费仅相当于每小时0.38美元。

英伟达的新GeForce RTX 4090的TDP为450W

在最坏的情况下,计算机具有你现在可以获得的最耗能的CPU和GPU组合(上面的卡和Intel的Core i9-13900K),两者都在其最高默认功率限制下运行,但仍然只需花费大约每小时0.50美元,用于相同的游戏程序。

你可能会争辩说,每小时50美分的游戏费用太高了,而对于全世界数百万人来说,这几乎可以肯定是正确的。但他们一开始不太可能拥有这样的PC。

就每年的出货量而言,家用游戏机比游戏PC更受欢迎,并且它们包含的硬件功能远不如上面给出的示例。但在功率需求方面,像微软的Xbox Series X这样的东西在活跃游戏期间只会消耗153W。

即使考虑到可能会再增加100W功率的大型OLED电视,这两款设备的能耗实际上也比单独的GeForce RTX 4090少44%。因此,如果电力成本是一个真正的问题,那么游戏机是游戏的一个很好的选择。

当然,并不是说你需要使用最新或最强大的PC部件来享受游戏。有很多旧的或中档的组件没有过高的功率需求,但仍然可以提供很多性能。

二手的Radeon RX 5700 XT、GeForce RTX 2060 Super,甚至GeForce GTX 1080 Ti显卡还是很能干的,三款TDP都在250W或更低。

简而言之,纯粹因为电力成本而增加电力是一个问题的论点在某种程度上是没有实际意义的——在很大程度上取决于当地的电力单位价格、游戏习惯等,无法最终解决这样的问题。辩论。

但是热量呢?

正如本文开头所提到的,几乎每一焦耳的电能最终都会以热量的形式消散,主要通过对流机制传递到环境中。

如果它使用电,它将散发热量。

理论上,一台输出900W的计算机可以在短短17分钟内将1000立方英尺(28立方米)空气的温度从20°C/68°F提高到40°C/104°F。这自然假设了完美的热传递和完美的绝缘,更热的空气没有移动到所讨论的体积之外。

虽然它实际上不会那么快,但实际上,所有热量最终仍会转移到PC的周围环境中,无论转移的速度如何。

冷却风扇,无论数量或性能如何,都不会改变这一点,因为它们只会帮助降低组件的温度。缓解环境热量上升的唯一方法是让受热的空气通过例如窗户开口移动到其他地方。

如果计划在你能获得的最强大的CPU和GPU上花费一大笔钱,那么请做好准备,因为它们会将大量热能倾倒到你的游戏室中。

900W的热量对一个人来说可能是一个长期问题,但对另一个人来说完全没问题。

多数人的需求大于少数人的需求

因此,对热量输出和电力成本的担忧似乎是非常个别的问题。然而,当在全球范围内扩展时,这一切都变得更加重要。

那里有数百万台PC,虽然封装250W+芯片的区域数量相对较少,但最终所有这些机器都将被配备比现在更高功率需求的组件的计算机所取代。

要了解这一点,请考虑一下估计全球已售出1700万台Xbox Series X和5000万台Xbox One游戏机。前者比后者使用大约90W的功率。

如果我们假设所有这些旧设备都被新设备取代,那就是额外的3GW累积电力需求,并最终消散了热量。显然,这些机器不会同时运行,但所需的额外能量并不是这个控制台独有的。

随着笔记本电脑、台式机、工作站和服务器的新处理器问世,它们都将需要更多的能量,无论是几瓦还是一百瓦。这反过来意味着能源行业将面临对其供应能力越来越高的需求。

由于人口和经济增长,无论如何都会出现这种情况,但半导体功率的增长只会使问题变得更加复杂。

即使考虑到PC销量多年来的下降,也有其他行业正在做相反的事情:物联网(IoT)、人工智能(AI)和大数据分析都显示出大量生长。

人工智能和大数据使用大量高端GPU来执行所需的计算,如果这些机器的新组件没有显示出缓和其电力需求的迹象,那么这些行业只会让能源状况变得更糟。

一些人估计,到2050年,全球范围内的电力需求将是现在的3倍,每年增长3%到4%。目前尚不清楚这些估计是否是处理器能耗增加的原因,尽管。

自2005年以来,预计全球电力产量已从18 PWh(1 PWh=1,000,000 GWh)上升到2021年的28 PWh——仅16年就增长了56%。而这种增长完全是因为需求增加。半导体使用量的增长只会在未来几十年增加。

那么,如果有的话,可以做些什么呢?

作为个人,你可以尝试很多方法来降低最大PC组件的功率需求。对于CPU,大多数主板在BIOS中都有多种电源选项,这将迫使处理器在空闲时降低其能耗。

高级配置和电源接口(ACPI)早在1996年就出现在台式计算机中,此后一直在不断更新。现在,所有消费类CPU都具有符合ACPI的特性,并且在功耗方面,有两个值得注意的特性:P状态和C状态。

前者是指处理器处于何种性能状态,在BIOS中启用时,可使芯片以较低的频率和电压运行,以节省能源。C状态做类似的事情,但控制CPU能够做什么(例如,在缓存中维护数据或将其完全刷新),同时以较低功率要求的格式运行。

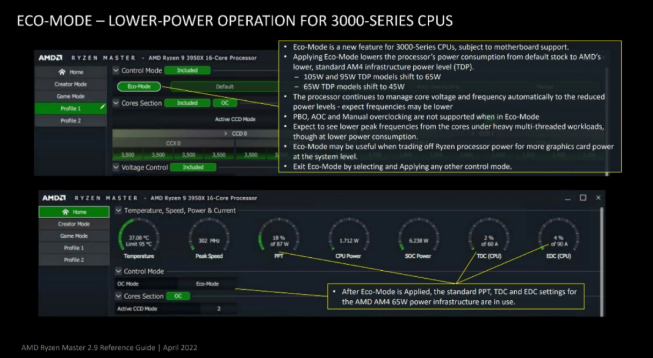

对于AMD较新的Ryzen处理器(3000系列以上),在其Ryzen Master软件中启用Eco模式将强制处理器以显著降低的TDP运行,而与启用的任何ACPI选项无关。

根据所使用的系统和测量的性能指标,使用较低功率值的影响可能非常小。

根据所使用的系统和测量的性能指标,使用较低功率值的影响可能非常小。对于英特尔CPU的用户,可以通过深入研究BIOS设置并寻找内部CPU电源管理来实现类似的功能(并非所有型号都有)。

在本节中,PL1和PL2的值可以设置为低于默认值,尽管它们更有可能以不同的名称列出。例如,华硕对PL1/PL2使用长/短包持续时间限制。

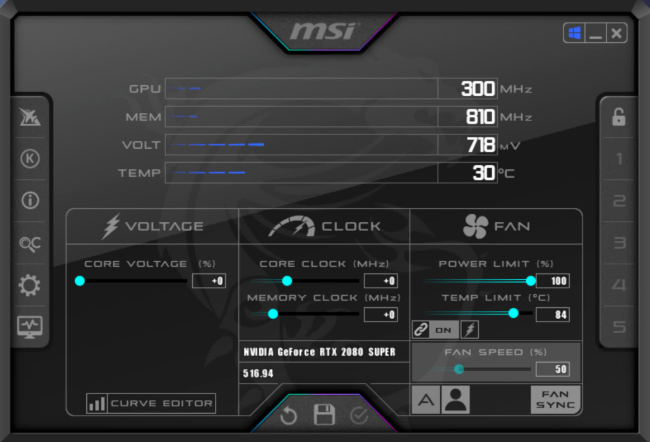

可以使用MSI Afterburner等软件以同样的方式调整显卡。此应用程序可以控制卡的最大功率限制,设置为百分比,并且可以轻松降低该数字。

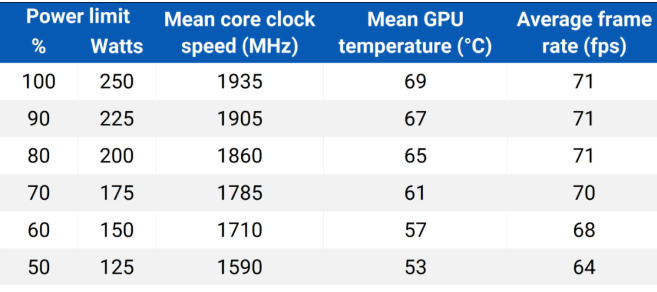

例如,Nvidia的RTX 2080 Super的100%功率限制为250W。将其降至70%会将GPU的功耗限制为175W。当然,这也会降低显卡的性能,但就像锐龙生态模式一样,影响并没有你想象的那么大。

类似的事情可以通过降低GPU的核心电压来实现,这反过来通常也需要降低时钟频率。或者,如果游戏提供了限制帧速率的选项,将其固定在较低的值也会降低功率需求。

但是为了简单起见,通过使用简单的滑块来调整功率限制是无法击败的。

我们使用上述显卡(RTX 2080 Super)和英特尔酷睿i7-9700K使用古墓丽影之影进行了一些快速测试。游戏的分辨率设置为4K,所有图形细节设置为最大值,启用了DLSS质量模式,但禁用了光线追踪。

最大可用功率降低50%只会导致平均帧速率降低10%(1%Low值下降不到5%),这似乎令人难以置信,但同样值得注意的是,这款游戏的高CPU负载。

DLSS的使用当然也有助于这项测试,因为游戏以比呈现的分辨率低得多的分辨率渲染,但GPU只会尝试以更快的速度渲染,并且仍然达到其功率限制。

显然,不同的游戏和硬件设置会产生与上述不同的结果,但在Red Dead Redemption 2(1440p,最高质量)中,功率限制降低50%会导致平均帧速率降低15%,而对于Far Cry 6的FPS下降仅为7%。

所以所有这一切都可能引出一个简单的问题——为什么硬件供应商将功率限制设置得如此之高,而这似乎是不必要的?

最可能的原因与营销和产品状态有关。AMD、英特尔和英伟达需要他们的模型尽可能清晰地区分,特别是在范围的光环末端。

这些产品应该是你能买到的最好的产品,所以使用的芯片将从分箱过程中选择,如果有足够的功率,这些芯片可以以最高时钟速度运行。

但这可能会导致类似GeForce RTX 3090 Ti的情况——它的TDP比3090高100W(高出29%),但即使在4K下,我们的测试也只显示它在游戏中快10%左右.

由于所有主要供应商都希望销售为他们制造的每一种可能的芯片,因此“好几个百分点”的模型不会消失,但设计人员当然可以降低功率需求。

硬件厂商需要做得更好

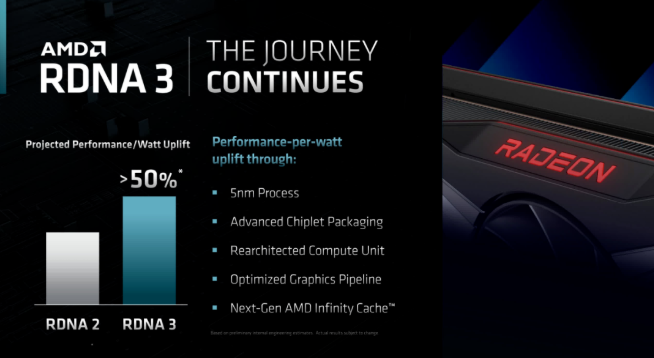

AMD等供应商大力宣传其产品的每瓦性能方面,并且通常将其用作关键卖点。例如,对于他们的下一个桌面GPU架构RDNA 3,改进预测是可观的。但是,这并不意味着Radeon RX 7000系列显卡的TDP会突然降低很多。

对于RDNA 2,AMD强调它的每瓦性能比之前的架构提高了65%。然而,Radeon RX 6800的TDP仍然是300W。

我们自己的测试验证了AMD声称的每单位功率性能大幅提高的说法,但这仍然不能削弱渲染能力的提高需要额外的能量来满足这一事实。

有人可能会争辩说,供应商应该更容易降低其产品的电力需求,甚至可能让它们在默认情况下以某种“生态模式”运行。

制造商可能会说他们已经这样做了,其形式是让他们的芯片在各种时钟级别(例如Turbo模式、升压时钟、游戏时钟)上运行,并让它们在空闲时显著降低电压。

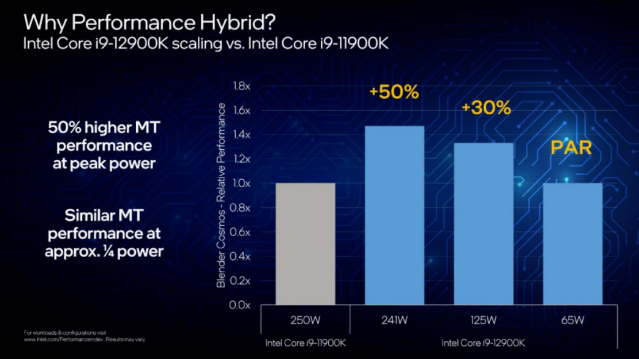

但当英特尔推出第12代酷睿台式机CPU时,新闻稿中充斥着性能声明,但只有一个部分敢于提及功率。

全新的CPU设计在同一个芯片中混合了两种不同的架构,显然是对等效的第11代模型的改进。如上图所示,英特尔本可以将TDP设置为95W,将PL2设置为125W,并且仍然能够拥有更高的性能。

相反,他们保留了与以前相同的数字,只是将PL2值降低了10W。这一切都是为了让产品在某些测试中比竞争对手快一点。

当然,你不必购买这些芯片,但是当需要进行升级或只是购买全新的计算机或游戏机时,你几乎没有选择接受这些耗电的产品,因为旧型号没有生产时间更长。

虽然调整CPU和GPU的功率限制相对容易,但可以说这是最终用户不应该做的事情。

可以说,太多的半导体制造商陷入了一种似乎与当今世界格格不入的思维模式——拥有尽可能高的性能,几乎不惜一切代价在竞争中脱颖而出。

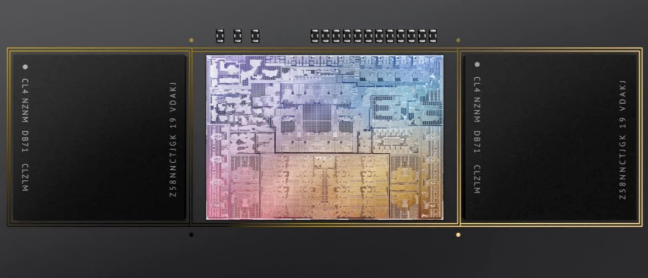

不过,隧道尽头有一些光亮。例如,Apple已将其几乎整个Mac和MacBook产品线转移到使用自己的M1/M2处理器。这些CPU+GPU组合处理器旨在尽可能节能,性能与AMD和Intel的x86产品相当,但功耗需求显著降低(游戏除外)。

服务器和工作站通常仍配备Intel Xeon或AMD Epyc处理器,但Apple使用的高能效Arm架构也正在向该领域扩展。大型云提供商正在用一些由Ampere的Altra模型提供支持的服务器替换他们的服务器。

改变即将到来,我们可能还需要很多年才能看到推出的新处理器的能耗要求低于其前任产品,但该行业正在朝着这一目标迈进。

与此同时,在个人层面上,我们可以做出一个简单的选择:接受最新硬件的电力需求并按原样使用它们(调整或不调整某些设置),或者用我们的钱包投票,让供应商知道数百个瓦特的功率太高了,无法支付。